Introdução

No experimento Moral Machine, onde são simuladas diversas situações de trânsito visando coletar os julgamentos das pessoas quanto à ação que o veículo autônomo deve tomar, segue minhas observações:

A partir da tabulação dos dados, foram identificadas nove preferências públicas, em ordem decrescente de confiança:

(1) Salvar vidas humanas;

(2) Salvar mais vidas;

(3) Salvar os mais jovens;

(4) Salvar os que cumprem as leis de trânsito;

(5) Salvar as pessoas de status social mais elevado;

(6) Salvar os mais magros em contraposição aos que têm sobrepeso;

(7) Salvar às mulheres em contraposição aos homens;

(8) Salvar os pedestres em contraposição aos passageiros;

(9) Que o veículo continue seu movimento.

Destas nove, três preferências públicas mais fortes foram identificadas, a saber: (i) Salvar vidas humanas; (ii) Salvar mais vidas; (iii) Salvar os mais jovens.

Fonte: AWAD, Edmond; DSOUZA, SOHAN; KIM, Richard; SCHULZ, Jonathan; HENRICH, Joseph; SHARIFF, Azim; BONNEFON, Jean-François; RAHWAN, Iyad. The Moral Machine Experiment. Nature, Vol. 563, 2018, p. 59-64.

1. O experimento "Moral Machine" falha por 2 motivos.

O primeiro por que em todas as simulações são feitas em terceira pessoa, nunca em primeira. A pessoa que simula deveria se colocar em primeira pessoa, ora enquanto passageiro, ora enquanto pedestre. O segundo por que as 3 preferências públicas mais fortes, quando selecionadas isoladamente, excluem as demais, ignorando possíveis relações que possam existir entre ambas, como relações de favorecimento e de exclusão (ver Jonathan Dancy, Practical Shape). Por exemplo, a 8ª preferência “Salvar os pedestres em contraposição aos passageiros”, não foi selecionada, mesmo tendo relação com todas as anteriores, a partir do momento que a mesma tem o poder de anulá-las sempre que a preferência se der entre passageiros e pedestres.

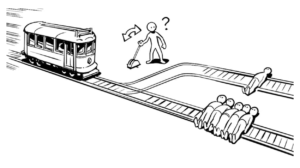

2. Trolley "Bystander at the Switch" x "The Fat Man" versions:

Na primeira versão, “Bystander”, o juízo moral do senso comum é praticamente unânime em acionar a alavanca para desviar o trem que segue em direção às 5 pessoas, ainda que ocasione a morte de uma pessoa que está amarrada ao trilho para o qual o trem é desviado; na versão “fatman”, o juízo moral do senso comum já muda, sendo praticamente unânime a opção em que não se deve jogar a pessoa robusta da ponte para salvar as 5 que se encontram amarrada ao trilho do trem (ver artigo NY Times). A situação é a mesma, porém as pessoas que desviam o trem na primeira versão mas que não jogam a pessoa robusta na segunda, não tomam uma decisão racional (apesar das explicações lógicas fornecidas).

Existe, portanto, condições adicionais que estão influenciando as escolhas dos agentes morais. Uma delas, conforme já apontado com a primeira falha do experimento Moral Machine, é que é necessário considerar esses experimentos colocando o agente moral também em primeira pessoa, qual seja, papel do bystander, da pessoa robusta, como uma das 5 pessoas amarradas ao trilho e também como a pessoa que se encontrada amarrada sozinha no trilho desviado.

3. Trolley versions x Moral Machine

Uma terceira falha do experimento Moral Machine é que esta não apresenta a irracionalidade existente entre as duas versões, bystander e fatman do trolley. Ao selecionar apenas as 3 preferências mais fortes em terceira pessoa, acaba representando apenas a versão bystander do trolley (ignorando assim os fatores que levam às diferenças entre os juízos morais nas duas versões).

4. Trolley "train driver version"

Nesta versão que criei abaixo – que com certeza alguém também já deve ter pensado – coloca, por exemplo, o bystander na posição de maquinista do trem.

O agente moral pode agora nesse experimento, simular como se sente, em primeira pessoa, em qualquer uma das 3 posições:

- no lugar do maquinista do trem;

- no lugar da pessoa amarrada sozinha no trilho desviado;

- no lugar de uma das cinco pessoas amarradas no trilho que será atingido pelo trem se não ocorrer o desvio;

5. Voltando agora ao Moral Machine...

Imagina você enquanto pedestre. Você aceitaria ser atingido e morto por um veículo autônomo à qualquer momento para preservar a vida dos passageiros deste veículo? Certamente que não. Por outro lado, imagine agora você enquanto passageiro. Bastaria ter 2 pessoas no carro para prevalecer o critério de salvar mais vidas e assim, atingir e matar o pedestre seguindo um princípio utilitarista e estaria em paz com sua consciência. Mas aceitar ser morto por um veículo autônomo para preservar a vida de 2 passageiros, você não quer, certo?

A questão é que o pedestre nada tem a ver com o veículo autônomo que sofre uma pane. Não foi ele quem contratou o serviço de transporte. Por que motivo ele deveria se sacrificar pelos passageiros?

Então o princípio de salvar mais vidas não se aplica entre pedestres e passageiros do veículo autônomo. Se aplica então, quando a colisão entre dois grupos de pedestres é inevitável, sendo necessário desviar e atingir o grupo “menos jovem”.

O “algoritmo” ficaria, para veículos autônomos, portanto:

- Entre danos materiais e humanos, preservar primeiro os humanos;

- Entre danos materiais e animais, boa pergunta… (não tenho resposta ainda)

- Entre humanos e animais, preservar primeiro os humanos;

- Entre passageiros e pedestres, preservar primeiro os pedestres;

- Entre pedestres e pedestres, preservar primeiro o grupo com maior número de pessoas, empatando, preservar o grupo mais jovem;

Até o item 3 está tudo bem (apesar da indefinição em relação ao item 2). Porém o que segue é que, neste algoritmo, a 8ª preferência, de “Salvar os pedestres em contraposição aos passageiros” tem prioridade sobre a 2ª de “Salvar mais vidas”.

Dessa forma, entre passageiros e pedestres, adota-se o princípio deontológico de “não matar”, ou seja, não matar os pedestres, que tem o poder de anular o princípio utilitarista de “salvar mais vidas”. O princípio contratualista, definido pela regra implementada no algoritmo, garante essa condição. Já entre passageiros e passageiros, adota-se o princípio utilitarista de “salvar mais vidas”, visto que, em qualquer opção haverá perda de vidas, então deve-se adotar a ação que preserve o maior número de vidas.

Supondo 2 grupos de pedestres com mesmo número de pessoas, em que ambas situações possuem a mesma probabilidade de matar todos os pedestres, então pode-se adotar as demais preferências na ordem de relevância do senso comum, como por exemplo, preservar o “grupo mais jovem”.

6. Agora vamos ao método do Equilíbrio Reflexivo quando utilizando os juízos morais do Moral Machine:

Fonte: Savulescu J, Gyngell C, Kahane G. Collective Reflective Equilibrium in Practice (CREP) and controversial novel technologies. Bioethics. 2021;00:1–12.

Neste caso, a aplicação do método do Equilíbrio Reflexivo (ER) falha por que partir de pressupostos já falhos do experimento Moral Machine, quando este, por sua vez, selecionou as 3 preferências mais fortes ignorando possíveis relações destas com as demais preferências.

Por esse motivo, também o método ER acaba por representar apenas o que seria a versão bystander do problema do trolley, tal como ocorreu no experimento Moral Machine. O desacordo moral que existe entre uma posição deontológica e utilitarista acaba desaparecendo, prevalecendo a posição contratualista de salvar mais vidas em virtude do desempate frente à teoria utilitarista.

Se não ignorarmos portanto o desacordo entre uma posição deontológica e utilitarista, veremos que o critério que define é, tanto para um lado quanto para outro, contratualista. Concluindo, segue que são regras definidas à nível de contrato que devem determinar os casos em que se deve salvar mais vidas, ainda que provoque mortes, ou que não se provoque a morte de ninguém com o objetivo de salvar um número maior de vidas. Em outras palavras, trata-se de um particularismo moral, uma vez que o resultado dependerá da situação que se apresenta.

Be the first to comment on "Método do Equilíbrio Reflexivo aplicado sobre os resultados do experimento Moral Machine"