CAPÍTULO 1 – INTRODUÇÃO

Um sistema é racional “se faz a coisa certa”, dado o que ele sabe. (p.3)

Capacidades Necessárias à I.A.

1- Processamento de linguagem natural

2- Representação de conhecimento

3- Raciocínio automatizado

4- Aprendizado de máquina

5- Visão computacional

6- Robótica

Estratégias de I.A.

1- Agindo de forma humana (a abordagem do teste de Turing)

2- Pensando de forma humana (a estratégia da modelagem Cognitiva)

3- Pensando Racionalmente (a abordagem das Leis do Pensamento)

4- Agindo Racionalmente (a abordagem de Agente Racional)

[4] Um Agente Racional é aquele que age para alcançar o melhor resultado ou, quando há incerteza, o melhor resultado esperado. (p.6)

[4] Na abordagem de “leis do pensamento” para IA, foi dada ênfase a inferências corretas. Às vezes, a realização de inferências corretas é uma parte daquilo que caracteriza um agente racional porque uma das formas de agir é racionalmente é raciocinar de modo lógico até a conclusão de que dada ação alcançará as metas pretendidas e, depois, agir de acordo com essa conclusão. Por outro lado a inferência correta não representa toda a racionalidade; em algumas situações não existe nenhuma ação comprovadamente correta a realizar, mas mesmo assim algo tem de ser feito. (p.6)

[4] A abordagem do agente racional tem duas vantagens sobre as outras abordagens. Primeiro, ela é mais geral que a abordagem de “leis do pensamento” porque a inferência correta é apenas um entre vários mecanismos possíveis para se alcançar a racionalidade. Em segundo lugar, ela é mais acessível ao desenvolvimento científico do que as estratégias baseadas no comportamento e pensamento humano. O padrão de racionalidade é matematicamente bem definido e completamente geral, podendo ser “desempacotado” para gerar modelos de agente que comprovadamente irão atingi-lo. (p.6)

[4] Devemos ter em mente um ponto importante: logo veremos que alcançar a racionalidade perfeita – sempre fazer a coisa certa – não é algo viável em ambientes complicados. (p.6)

Fundamentos da IA

Pessoas diferentes abordam IA com objetivos diferentes em mente. Duas questões importantes são: Você se preocupa com pensamento ou com o comportamento? Você quer modelar seres humanos ou trabalhar a partir de um padrão ideal? (p.27)

Filosofia: Os filósofos tornaram a IA concebível, considerando as ideias de que a mente é, em alguns aspectos, semelhante à uma máquina, de que ela opera sobre o conhecimento codificado em alguma linguagem interna e que o pensamento pode ser usado para escolher as ações que deverão ser executadas. (p.27)

Matemática (lógica, computação e probabilidade): Os matemáticos forneceram as ferramentas para manipular declarações de certeza lógica, bem como declarações incertas e probabilísticas. Eles também definiram a base da compreensão da computação e do raciocínio sobre algoritmos. (p.27)

Economia: Os economistas formalizaram o problema de tomar decisões que maximizam o resultado esperado para o tomador de decisões. (p.27)

Neurociência: Os neurocientistas descobriram alguns fatos sobre como a mente trabalha e a forma como ela se assemelha e se diferencia dos computadores. (p.27)

Psicologia: Os psicólogos adotaram a ideia de que os seres humanos e os animais podem ser considerados máquinas de processamento de informações. Os linguistas mostraram que o uso da linguagem se ajusta a esse modelo. (p.27)

Engenharia de Computadores: Os engenheiros de computação forneceram máquinas cada vez mais poderosas que tornam possíveis as aplicações de IA. (p.27)

CAPÍTULO 2 – AGENTES INTELIGENTES

Um agente é tudo o que pode ser considerado capaz de perceber seu ambiente por meio de sensores e de agir sobre esse ambiente por intermédio de atuadores. (p.31)

2.2.1 Racionalidade

A definição do que é racional em qualquer instante dado depende de quatro fatores:

- A medida de desempenho que define o critério de sucesso

- O conhecimento prévio que o agente tem do ambiente

- As ações que o agente pode executar

- A sequência de percepções do agente até o momento (p.34)

2.2.2. Onisciência, aprendizado e autonomia

Precisamos ter o cuidado de distinguir entre realidade e onisciência. Um agente onisciente sabe o resultado real de suas ações e pode agir de acordo com ele; porém, a onisciência é impossível na realidade.

A racionalidade maximiza o desempenho esperado, enquanto a perfeição maximiza o desempenho real. Fugir à exigência da perfeição não é apenas uma questão de ser justo com os agentes. Se esperarmos que um agente realize aquela que virá ser a melhor ação após o fato, será impossível projetar um agente para satisfazer essa especificação, a menos que melhoremos o desempenho de bolas de cristal ou máquinas do tempo. (p.35)

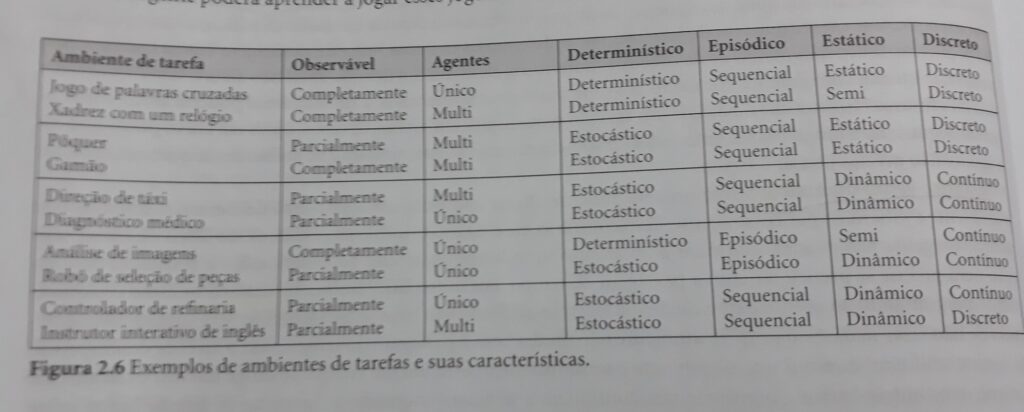

2.3.2. Propriedades de ambientes de tarefas

1- Ambiente completamente observável x parcialmente observável

- Um ambiente de tarefa é completamente observável se os sensores detectam todos os aspectos que são relevantes para a escolha da ação;

- Um ambiente de tarefa poderia ser parcialmente observável devido ao ruído e a sensores imprecisos ou porque partes do estado estão simplesmente ausentes nos dados do sensor;

- Um ambiente inobservável seria a condição do agente não tiver sensores;

2- Agente único x Multiagente: A distinção entre ambientes de agente único e multiagente pode parecer bastante simples. … Porém, existem algumas questões sutis, como: um agente A (como por exemplo um motorista de táxi) tem de tratar um objeto B (outro veículo) como um agente ou ele pode ser tratado apenas como um objeto comportando-se de acordo com as leis da física, análogo às ondas no mar ou às folhas espalhadas pelo vento? A distinção fundamental é saber se o comportamento de B é ou não melhor descrito como a maximização da medida de desempenho cujo valor depende do comportamento do agente A. Por um lado, no ambiente de direção de um táxi, evitar colisões maximiza a medida de desempenho de todos os agentes, assim esse é um ambiente de multiagente parcialmente cooperativo. Ele também é parcialmente competitivo porque, por exemplo, apenas um carro pode ocupar o espaço no estacionamento. Os problemas de projetos de agentes que surgem em ambientes de multiagentes muitas vezes são bem diferentes dos que surgem em ambientes de um único agente;

3- Determinístico x Estocástico: Se o próximo estado do ambiente é completamente determinado pelo estado atual e pela ação executada pelo agente, dizemos que o ambiente é determinístico; caso contrário, ele é estocástico. Em princípio, um agente não precisa se preocupar com a incerteza em um ambiente completamente observável e determinístico. Porém, se o ambiente por parcialmente observável, ele poderá parecer estocástico. A maioria das situações reais é tão complexa que é impossível acompanhar todos os aspectos não observados; para finalidades práticas devem ser tratados como estocásticos. O motorista de taxi é claramente estocástico nesse sentido por que nunca pode prever o comportamento do tráfego com exatidão. Dizemos assim que um ambiente é incerto se não for totalmente observável ou determinístico. O nosso uso da palavra estocástico geralmente implica que a incerteza sobre os resultados é quantificada em termos de probabilidades; um ambiente não determinístico é aquele que as ações são caracterizadas por seus resultados possíveis, sem probabilidade associada a ele (as descrições do ambiente não determinístico são normalmente associadas às medidas de desempenho que exigem que o agente tenha sucesso em todos os resultados possíveis de suas ações.

4- Episódico x Sequencial: Em um ambiente de tarefa episódico, a experiência do agente é dividida em episódios atômicos. Em ambientes episódicos, a escolha da ação em cada episódio só depende do próprio episódio. Por outro lado em ambientes sequenciais, a decisão atual poderia afetar todas as decisões futuras. Ambientes episódicos são muito mais simples do que ambientes sequenciais por que o agente não precisa pensar à frente.

5- Estático x Dinâmico: Se o ambiente puder se alterar enquanto um agente está deliberando, dizemos que o ambiente é dinâmico para esse agente; caso contrário, ele é estático. Se o próprio ambiente não mudar com a passagem do tempo, mas o nível de desempenho do agente se alterar, diremos que o ambiente é semi-dinâmico.

6- Discreto x Contínuo: Aplica-se ao estado do ambiente, ao modo como o tempo é tratado, e ainda às percepções e ações do agente. Por exemplo, um jogo de xadrez tem um número finito de estados distintos e um conjunto discreto de percepções e ações. Já dirigir um táxi é um problema de estado e tempo contínuo: a velocidade e a posição do táxi e de outros veículos passam por um estado de valores contínuos ao longo do tempo.

7- Conhecido x Desconhecido: Essa distinção não se refere ao ambiente em si, mas ao estado de conhecimento do agente sobre as “leis da física” no meio ambiente. Em um ambiente conhecido, são fornecidas as saídas (ou probabilidades de saídas se o ambiente for estocástico) para todas as ações. Obviamente se o ambiente for desconhecido, o agente terá que aprender como funciona, a fim de tomas boas decisões (essa distinção não é a mesma coisa que entre ambientes totalmente e parcialmente observáveis).

Observe que o caso mais difícil é parcialmente observável, multiagente, estocástico, sequencial, dinâmico, contínuo e desconhecido. (p.38-40)

2.4.1. Programas de agentes

São quatro tipos básicos de programas de agentes que incorporam os princípios subjacentes a quase todos os sistemas inteligentes:

- Agentes reativos simples

- Agentes reativos baseados em modelo

- Agentes baseados em objetivos

- Agentes baseados na utilidade

- Agentes com aprendizagem

Cada tipo de programa de agente combina componentes específicos de maneiras específicas para gerar ações. A seção 2.4.6. explica, em termos gerais, como converter todos esses agentes em agentes de aprendizagem que podem melhorar o desempenho de seus componentes de modo a gerar melhores ações. (p.42)

2.4.2. Agentes reativos simples: Esses agentes selecionam ações com base na percepção atual, ignorando o restante histórico de percepções. Comportamentos reativos simples ocorrem mesmo em ambientes mais complexos. Imagine-se como motorista de um táxi automatizado. Se o carro da frente frear e as suas luzes de freio se acenderem, você deve notas esse fato e começar a frear. Em outras palavras, algum processamento é realizado de acordo com a entrada visual para estabelecer a condição que chamamos “O carro da frente está freando”. Então, isso ativa alguma conexão estabelecida no programa do agente para a ação “começar a frear”. Chamaremos tal conexão de regra condição-ação (regra se-então), escrita como:

se carro da frente está freando, então começar a frear

2.4.3. Agentes reativos baseados em modelos: O modo mais efetivo de lidar com a possibilidade de observação parcial é o agente monitorar a parte do mundo que ele não pode ver agora. Isto é, o agente deve manter algum tipo de estado interno que dependa do histórico de percepções e assim reflita pelo menos alguns dos aspectos não observados do estado atual.

A atualização dessas informações internas de estado à medida que o tempo passa exige que dois tipos de conhecimento sejam codificados no programa do agente: 1) informações sobre o modo como o mundo funciona/evolui independente do agente; 2) informações sobre como as ações do próprio agente afetam o mundo. Esse conhecimento de “como o mundo funciona – seja ele implementado em circuitos booleanos simples ou em teorias científicas completas – é chamado de modelo de mundo. Um agente que usa tal modelo denomina-se agente baseado em modelo.

2.4.4. Agentes baseados em objetivos: Semelhante ao agente baseados em modelos, a diferença é que para os agentes baseados em objetivos, o que determina a ação não é uma ou mais regras do tipo se-então. Em vez disso um objetivo fixo ou dinâmico orienta que ação ou sequência de ações devem ser tomadas.

2.4.5. Agentes baseados na utilidade: Os agentes baseados na utilidade incorporam aos agentes baseados em objetivos medidas de desempenho, ou seja, preocupam-se também quanto à forma mais eficiente de se atingir o objetivo (e não simplesmente atingir o objetivo ignorando o esforço requerido para fazê-lo).

A função “utilidade do agente” é essencialmente uma internalização da medida de desempenho.

Observabilidade parcial e estocasticidade são onipresentes no mundo real e assim, portanto, trata-se de uma tomada de decisão sob incerteza. Tecnicamente falando, um agente racional baseado em utilidade, escolhe a ação que maximiza a utilidade esperada dos resultados da ação, isto é, a utilidade que o agente espera obter, em média, dadas as probabilidades e as utilidade de cada resultado.

2.4.6. Agentes com aprendizagem:

–

PARTE II – RESOLUÇÃO DE PROBLEMAS

6. Problemas de satisfação de restrições

Be the first to comment on "I.A."